什么是Elasticsearch集群脑裂?

当网络抖动或节点负载过高时,Elasticsearch集群中的主节点(master)与部分数据节点失去通信,剩余节点重新选举出新主节点,导致**同一集群出现两个主节点**的现象,即为脑裂(split-brain)。

脑裂的直接后果是索引数据被**并行写入不同分片副本**,最终产生**数据不一致**,严重时需要全量重建索引。

---脑裂产生的常见场景

- 网络分区:交换机故障、云厂商网络抖动,导致节点间心跳超时。

- GC停顿:老年代回收时间过长,节点无法及时响应集群状态ping。

- master节点负载过高:同时承担数据节点角色,CPU被打满。

如何快速诊断是否发生脑裂?

自问:集群健康状态突然变red,且_cat/master返回两个不同节点ID,是否一定脑裂?

答:不一定。先执行以下命令确认:

GET /_cluster/state/master_node

GET /_cat/nodes?v若两条命令返回的master_node值不同,且**两个节点都显示自己是master**,则脑裂已发生。

---解决脑裂的四个核心步骤

1. 立即隔离异常节点

使用防火墙或云安全组**临时封禁异常节点的9300端口**,阻止其继续广播错误集群状态。

2. 强制选举唯一主节点

在存活节点中,选择**拥有最新集群状态版本**的节点,重启其他候选master:

curl -X POST "localhost:9200/_cluster/voting_config_exclusions/nodeId"3. 调整最小主节点数

在elasticsearch.yml中设置:

discovery.zen.minimum_master_nodes: (master_eligible_nodes / 2) + 1对于7.x及以上版本,改用:

cluster.initial_master_nodes: ["node-1","node-2","node-3"]4. 数据一致性校验

使用**Elasticsearch Checksum Tool**对比分片副本:

GET /_cat/shards?v&s=state对state为UNASSIGNED的分片执行:

POST /_cluster/reroute?retry_failed=true节点无法加入集群的排查清单

网络连通性检查

- telnet 目标节点9300端口是否通

- 抓包确认节点间是否交换**Zen Discovery ping请求**

集群名称一致性

自问:节点配置文件中cluster.name是否拼写错误?

答:执行grep cluster.name /etc/elasticsearch/elasticsearch.yml确保所有节点完全一致。

节点角色冲突

若新节点配置为:

node.master: false

node.data: false则该节点为**协调节点**,不会出现在集群状态API中,易被误判为“未加入”。

---实战案例:一次因MTU导致的节点失联

某金融客户扩容集群时,新购云主机MTU设置为9000,而原集群为1500。节点日志显示:

[WARN ] received ping response with no matching id解决方案:

- 临时调低新节点MTU:

ifconfig eth0 mtu 1500 - 在elasticsearch.yml添加:

transport.tcp.compress: true

预防脑裂的运维规范

| 维度 | 推荐值 | 风险 |

|---|---|---|

| master节点数 | 3或5个奇数 | 偶数易产生平票 |

| 网络延迟 | <100ms | 超时易触发重选 |

| 监控告警 | 连续3次ping失败 | 提前人工干预 |

节点扩容时的最佳实践

1. **滚动重启**:每次只重启一个节点,等待集群状态green再继续。

2. **使用分片分配感知**:

cluster.routing.allocation.awareness.attributes: rack_id3. **预分配分片**:

PUT /_cluster/settings

{

"transient": {

"cluster.routing.allocation.enable": "primaries"

}

}终极提问:如何彻底避免脑裂?

答:无法100%避免,但可通过以下组合将概率降至0.1%以下:

- 独立master节点池(不存储数据)

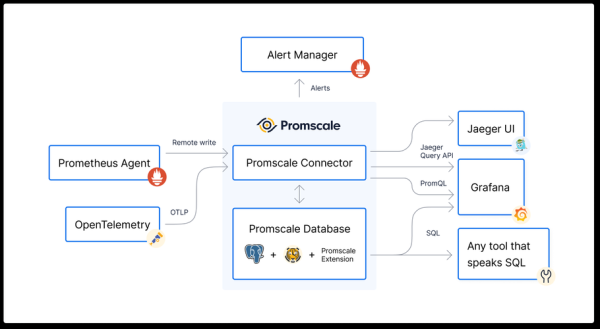

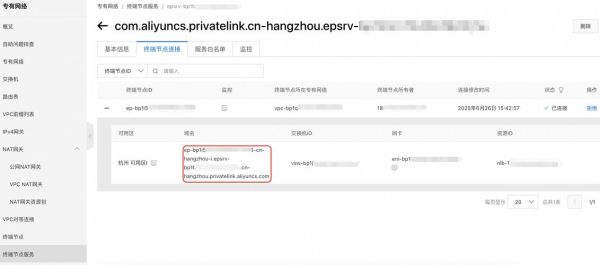

- 跨可用区部署+专用网络通道

- 启用**cluster.routing.allocation.disk.threshold_enabled**防止磁盘写满

- 定期执行**快照备份**(即使脑裂也可快速回滚)

还木有评论哦,快来抢沙发吧~